如何优化SEO提高网站搜索排名

在当今互联网时代,搜索引擎优化(SEO)已成为数字营销中不可或缺的一部分。无论是企业网站、个人博客还是电商平台,通过优化SEO技术来提升网站的搜索排名,从而吸引更多流量和潜在用户,已经成为站长和 marketers 的核心目标之一

然而,对于许多刚开始接触 SEO 的人来说,面对复杂的算法、海量的技术细节以及不断变化的搜索引擎规则,可能会感到无从下手。如何系统地优化网站?哪些技巧才是最有效的?这些问题常常困扰着 SEO 初学者和从业者

本文旨教你通过科学的方法提升网站在搜索引擎中的排名,实现流量和转化率的双丰收

什么是SEO

SEO(Search Engine Optimization) 是一种通过优化网站内容、结构和技术等方面,以提高网站在搜索引擎自然搜索结果中的排名和可见性的过程。其核心目标是增加有机流量(organic traffic),即通过搜索引擎直接点击进入网站的访问量

搜索引擎工作原理

搜索引擎的工作流程可以分为以下几个主要步骤:抓取、索引、排名和反馈。每个步骤都有其独特的功能,共同确保用户能够快速找到所需信息

抓取:搜索引擎通过爬虫从预定义的种子 URL 开始抓取,通过页面中的超链接(URL)从一个网页跳转到另一个网页,逐步扩大抓取范围。爬虫会遵循robots.txt文件的规则,避免访问不应该被抓取的内容索引:搜索引擎分析网页内容,提取关键词、元标签、标题等信息,将这些信息组织成易于搜索的结构,类似于书籍的目录,使得用户输入关键词时能够迅速定位到相关页面排名:当用户输入搜索词时,搜索引擎根据预设算法对相关网页进行排序,确定展示结果的顺序。通常要评估搜索词与网页内容的相关程度,分析反向链接的数量和质量,判断网页的重要性,考虑网页加载速度、移动端适配性、用户点击率等因素展示结果:搜索引擎通过记录用户的点击行为和搜索历史,了解哪些结果更符合用户的期望,排序后的结果以列表形式展示给用户,通常包括标题、描述和链接

技术优化

技术优化需要在开发网站前期就要做好准备,开发中需要谨慎对待页面受影响的指标,同时应随时进行性能测试

标题与描述

title:确保每个页面的标题唯一且包含关键词,例如:“有机苹果 – 100%天然有机食品”,标题长度应控制在60个字符以内,标题权重占比最高description:元描述应简洁明了,包含关键词,并吸引用户点击keywords:文章关键词

图片

img地址应使用描述性且包含关键词的文件名,例如:“organic-apples.jpg”;压缩图片,减少文件体积(推荐使用webp格式);图片标签中加入有意义的Alt文本,包含关键词,并描述图片内容

HTML语义化

使用 <header>、 <footer>、 <nav>、 <article> 等语义化标签,帮助搜索引擎理解页面结构,避免不必要的标签层级,确保代码简洁清晰

页面速度优化

网站的响应速度是用户体验和搜索引擎排名的重要指标之一,如:资源大小、HTTP2/3、图片、缓存等等,这里就不详细展开了。开发者可借助 lighthouse 测评网站的各个性能指标,然后根据指标提示进行优化

URL结构

- URL 长度过长会影响用户体验,也可能会被搜索引擎降权

- 自然地融入与内容相关的关键词,但不要堆砌

- URL 的层级(斜杠 / 的数量)应尽量简洁,一般不超过三层

- 避免使用动态参数

- 每个页面的 URL 必须唯一,避免重复内容

移动端适配

使用媒体查询确保网站在不同屏幕尺寸上显示良好,减少移动设备上的资源消耗,提升用户体验

站点地图(Sitemap)

Sitemap帮助搜索引擎爬虫发现不易通过内部链接访问的页面(如孤岛页面、动态生成的页面),对新网站或大规模网站尤为重要,可加速新内容的收录

首先生成XML或TXT站点地图,可使用在线工具(如Screaming Frog、XML-Sitemaps.com)或静态网站生成器(如Hugo、Jekyll)

然后可以在robots.txt中进行声明,内容变动后需及时更新站点地图,确保搜索引擎获取最新信息

robots.txt

robots.txt 是一个文本文件,位于网站的根目录下,用于指示网络爬虫(如搜索引擎的爬虫)如何访问和抓取网站的内容。它通过指定允许或禁止爬虫访问的路径,帮助网站管理员控制爬虫的行为,从而优化网站的抓取效率和保护敏感内容

robots.txt 文件主要由以下几个配置项组成:

- User-agent: 用于指定规则适用的爬虫名称

*:表示所有爬虫。Googlebot:Google 的爬虫。Bingbot:Bing 的爬虫。Baiduspider:百度的爬虫。 示例:

User-agent: *

User-agent: Googlebot2

- Disallow: 用于禁止爬虫访问特定的路径或页面。可以指定一个或多个路径

Disallow: /private/

Disallow: /admin/2

如果要禁止访问所有内容,可以使用:

Disallow: /- Allow: 用于允许爬虫访问特定的路径或页面,通常与

Disallow配合使用,以允许某些例外情况

Allow: /public/

Allow: /images/2

- Sitemap: 用于指定网站的站点地图(Sitemap)文件的 URL,帮助爬虫更好地抓取网站内容

Sitemap: https://example.com/sitemap.xml一个robots.txt完整示例:

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: https://www.example.com/sitemap.xml2

3

4

5

6

7

外链建设与内部链接

外链建设和内部链接管理是提升网站权威性和用户体验的重要因素

外链价值与获取方式

外部链接被视为对网站内容的认可,有助于提升网站的域外权威性。高质量的外部链接可以带来更多的访问量

通过发布高质量文章或资源,吸引其他网站自然引用你的内容。与其他网站或博客合作,通过分享专业知识获得外部链接机会。如果可能,可与其他网站进行资源互换,实现互利共赢

内链优化

通过相关链接引导用户探索更多内容,减少跳出率;帮助搜索引擎更全面地抓取网站内容,提升索引量

在内容中自然插入与主题相关的其他文章或资源的链接。例如,在科技新闻文章中链接到类似的技术解析或历史背景;减少层级深度,使用户和搜索引擎更容易访问所有页面

内容为王(打造高质量的内容)

高质量内容是能够满足用户需求、提供独特价值,并且符合搜索引擎算法要求的内容。它不仅仅是文字的堆砌,而是以用户为中心,兼具实用性和可读性

高质量内容的核心要素

- 原创性:内容必须具有独特的见解或视角,避免简单复制

- 相关性:内容与目标受众的需求高度匹配

- 实用性:为用户提供解决问题的方案、知识或资源

- 可读性:语言简洁明了,结构清晰,易于理解

- 权威性:通过专业性和可信度赢得用户和搜索引擎的认可

内容更新与维护

定期检查和更新内容,确保信息准确性和时效性。根据用户反馈优化内容结构或添加新功能

分析与调整

SEO效果的监控工具

在实施SEO策略后,及时监控和评估其效果是至关重要的。合适的工具可以帮助我们量化SEO的表现,并根据数据反馈进行必要的调整。以下是几种常用的SEO效果监控工具

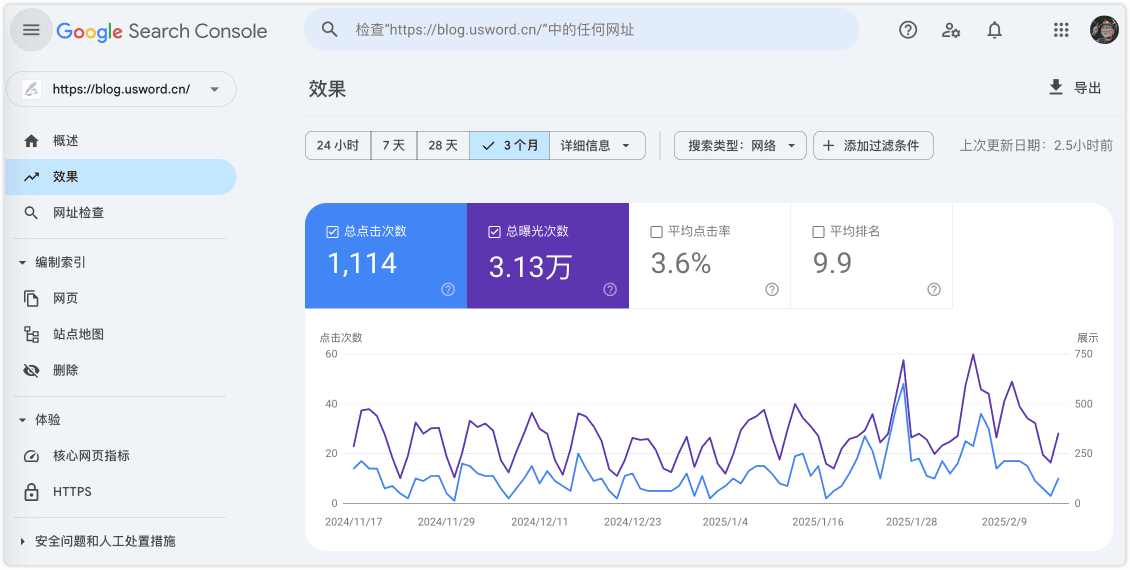

- Google Search Console:监控网站在Google搜索中的表现,支持搜索流量报告,包括点击率(CCTR)、展示次数、排名等,发现和修复爬虫问题

- Ahrefs:监测特定关键词在不同搜索引擎上的排名变化;通过反向链接(Backlink)数据评估网站的外部SEO表现

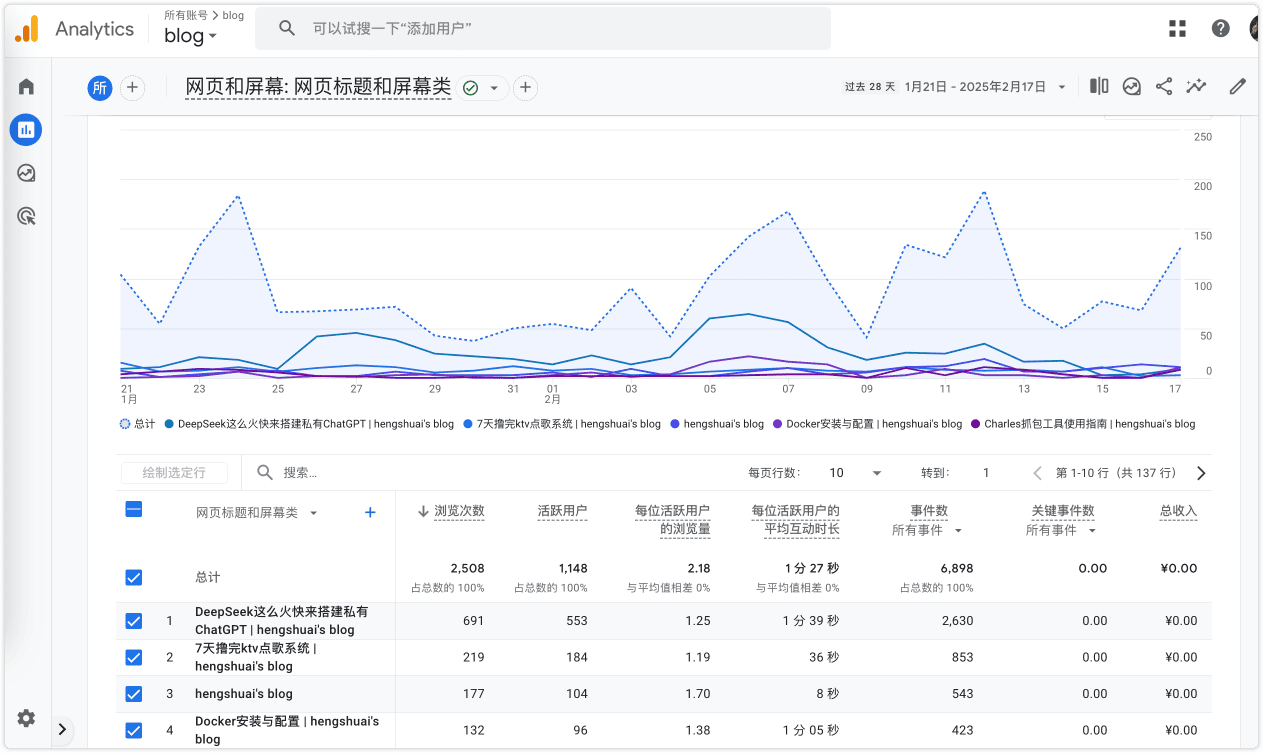

- Google Analytics(GA):跟踪网站流量来源和用户行为数据,分析跳出率、停留时间等指标,评估内容对用户吸引力,配合Google Search Console使用,全面了解SEO效果

Google Analytics通常用作网站的埋点

数据分析与策略调整

有效的SEO不仅依赖于工具的选择,还需要基于数据进行持续的分析和策略调整

使用Google Analytics查看流量来源,区分自然搜索(organic)和广告流量。Ahrefs或SEMrush中的关键词排名数据,了解哪些关键词带来最多流量,观察关键词排名的趋势变化,判断SEO策略的效果;对比竞争对手在相同关键词的表现,识别差距并制定改进措施

定期回顾SEO效果报告,评估各项指标的变化趋势

SPA应用搜索引擎会收录吗

大家知道SSR和SPA最大的差距就是前者在服务端就生成好了页面内容,适用于搜索引擎录取,而SPA单页应用,Single Page Application)是一种现代Web应用架构,现代搜索引擎(如Google)已经能够较好地处理JavaScript渲染的内容,因此SPA应用的内容可以被收录

但并非所有搜索引擎都能很好地处理JavaScript内容,尤其是较旧的或较小的搜索引擎可能无法正确抓取和索引SPA的内容

参考文献

总结

通过系统地实施这些SEO优化技巧,你可以显著提升网站的搜索排名和流量。记住,SEO是一个持续改进的过程,需要不断学习新知识并适应搜索引擎算法的变化。保持耐心,逐步优化,你将看到网站流量和转化率的显著提升!